中兴通讯数据中心全场景制冷方案,构建绿色高效的数据中心

在数字经济加速演进的背景下,中兴通讯以“连接+算力”为战略核心,将数据中心作为算力基础设施的关键载体,伴随AI大模型、云计算等技术的广泛应用,数据中心算力需求激增。据工业和信息化部的最新数据显示,2024年在用算力中心标准机架数超过880万架,算力规模同比增长16.5%,且单机柜功率向高密化发展,传统制冷技术已难以满足极端能效、弹性部署及智能运维需求。为此,中兴通讯依托自研温控产品矩阵,构建“风-液-蒸发”多技术协同的全场景制冷体系,以智能连接技术优化算力基础设施能效,以算力需求牵引制冷方案迭代,助力客户构建绿色高效的数据中心。

数据中心制冷方案发展趋势

在算力密度攀升与“双碳”目标驱动下,数据中心制冷技术演进呈现三大核心趋势:高热密度场景催生极端散热技术突破,传统风冷面临能效瓶颈;业务动态扩容推动模块化弹性部署;复杂负载场景倒逼智能运维与全生命周期管控升级。

高密散热与极端能效

服务器功率密度显著提升,部分机柜已突破100kW,远超传统5~10kW水平;先进制程芯片功耗持续攀升(单芯片超1000W),集成度更高,对散热精度和效率提出更严苛要求,传统风冷技术面临瓶颈。为满足国家枢纽节点要求东(西)部 PUE ≤1.25(1.2)指标,并进一步追求PUE低于1.1的目标,液冷技术成为关键解决方案。面对大规模计算集群产生的成倍增长的散热需求,高密度散热技术成为同步提升算力密度与能源效率、支撑未来高性能计算场景不可或缺的技术支撑。

模块化与弹性部署

数据中心业务更新迭代加速,传统集中式制冷系统建设周期长,难以及时响应“按需扩容”的要求;边缘计算等场景的业务波动性和不确定性,对制冷系统的快速部署和灵活调整能力提出了更高标准。模块化设计成为主流方向。采用预制化、标准化的制冷模块,实现即插即用,能显著缩短交付时间,并动态匹配算力增长与制冷资源需求。这种模式避免了前期过度投资造成的资源闲置和浪费,有效降低建设成本,推动数据中心向更高效、可持续的弹性部署模式发展。

智能运维与全生命周期管理

制冷系统运维成本高昂,据行业统计,可占数据中心人力成本的80%,传统运维依赖人工监控和经验决策,效率低、故障响应滞后,难以在复杂多变的负载条件下实现能源的精准管理与优化,智能化与全生命周期管理成为核心方向。通过实时监控系统动态跟踪和分析制冷设备状态,利用AI算法优化运行效率,智能化运维平台能够预测潜在故障、自动调节运行参数,实现能源的高效分配与精细化管理,从而大幅提升数据中心运行的可靠性、能源分配效率和管理精细化水平。

中兴通讯“连接+算力”战略下的温控解决方案

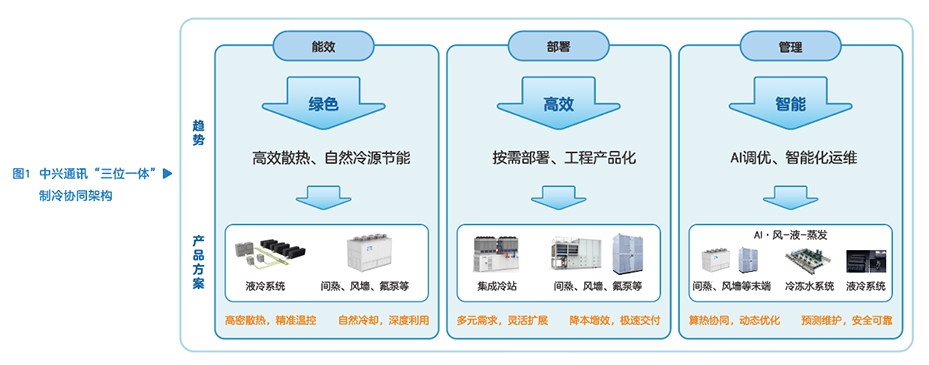

基于上述三大核心趋势,中兴通讯提出“三位一体”的制冷协同架构:以模块化风墙适配中低密中高温冷冻水冷源场景需求,以间接蒸发冷却空调覆盖中低密纯风冷场景,以液冷系统突破高密场景散热瓶颈(见图1)。三大技术路径既可独立部署,亦可形成“风冷液冷协同”的混合架构,全面覆盖数据中心从边缘节点到核心枢纽的多样化需求。通过模块化预制理念实现即插即用与弹性扩容,结合AI算法驱动能效管控与智能运维,最终达成绿色低碳、高效部署与全生命周期智能化管理的目标。

模块化风墙

中兴通讯模块化风墙以“模块化架构+智能调控”为核心,聚焦数据中心中低密场景的高效制冷需求,同时可作为冷板式液冷场景中协同的风冷方案。模块化风墙采用预制化、标准化、模块设计,支持单机独立、双机冗余及多机集群并联模式,可实现即插即用与灵活扩容,部署周期缩短60%以上;通过双层保温面板+高温冷冻水设计,系统能效比≥20,较传统方案节能30%以上;搭载PICV调节阀与PLC主控平台,结合AI算法实现水力平衡自动化调控与负载自适应调速,动态匹配算力负载波动。模块化冗余设计(如双路电源ATS切换)与高可靠性部件,保障极端环境稳定运行。

在印尼DCI数据中心应用案例中,针对印尼热带高温高湿环境(年均温25℃~32℃,湿度70%~90%),中兴通讯部署70多套ZXETM F510模块化风墙,采用预制化设计,部署工期缩短60%,同步完成调试;采用15℃冷冻水控温与送风21℃/50%,项目实现PUE<1.25,满足高温环境能效要求;结合G4过滤器与机房正压(≥10Pa)防尘方案,运维成本降低40%。该案例验证了模块化风墙在复杂气候条件下的快速部署、高效制冷能力,同时为“东数西算”枢纽节点建设提供了可复用的绿色温控经验。

间接蒸发冷却空调

中兴通讯间接蒸发冷却空调基于“空气-空气换热芯体+喷淋蒸发”协同制冷,第三代产品ZXETM E400E采用自研高分子芯体,换热效率提升5%,支持干/湿/混模式智能切换,最大限度利用自然冷,满足国家枢纽节点对PUE的要求;部件模块化组合,搭配集装箱框架,单机组吊装仅需半小时,适配“按需、灵活扩容”需求;自研温控平台与AI算法,集成多种传感器,实时监测环境与负载,动态优化运行模式,制冷负载系数CLF可降低10%以上;IP55防护与8烈度抗震设计保障极端环境可靠性,芯体全生命周期免更换,喷淋系统节水耐用。

在建设银行和林格尔数据中心案例中,部署480套中兴通讯间接蒸发冷却空调(降容后单机制冷量230kW),通过自然冷源高效利用与智能模式切换实现PUE≤1.2,较传统方案节能60%;智能预警系统监测300+参数,故障响应缩短至分钟级;平均半小时即可完成1台机组的吊装/就位/固定,剩余安装工作仅需对接水管、风管。项目验证了方案在大型数据中心的规模化应用价值,为“东数西算”枢纽节点金融行业数据中心低碳建设提供标杆。

液冷系统

中兴通讯液冷系统以“高密散热+模块化架构+智能调控”为核心,适配AI训练集群等极端高密场景需求。冷板式液冷系统ZXETM L200M CDU采用模块化架构,通过增加插箱模块配置,制冷量可弹性扩展至1200kW,单位面积制冷量达1600kW/m2。系统通过智能群控模块实时同步算力节点温度,高精度恒温控制,智能判断设备运行状态,优化控制逻辑,实现液冷系统内各类设备的智能联调,风液系统联动寻优,较传统控制方案可提升节能效果5%。通过软件功能实现智能运维管理和数据可视化,最大程度提升运维效率。冷板式液冷较传统最优风冷方案节能18%以上,节水55%以上,为高密散热场景提供高效精准温控方案。

在中国电信浙江金华数据中心案例中(见图2),部署24个液冷机柜(单柜35kW),配套6套ZXETM L300 CDU(单套300kW),一次侧供水35℃、二次侧供液40℃,利用冷却塔自然冷源预冷高温回风,自然冷却时长延长3156小时;通过液冷与风冷冷源共享设计,投资成本降低25%;预留热回收接口,接入相邻机楼水冷系统并配置蓄冷罐,实现15分钟连续供冷与能源复用。项目整体PUE<1.2,验证了液冷系统在高密场景下的节能性与稳定性,为AI大模型训练中心建设提供了低碳、高可靠的参考样本。

中兴通讯以“连接+算力”为战略核心,通过模块化风墙、间接蒸发冷却空调、液冷等产品矩阵,实现“冷源-算力-管理”的全链路连接。目前,正在开发的两相浸没液冷产品将进一步提升散热效率,支撑单机柜功率密度突破100kW。未来,中兴通讯将深化制冷与算法的融合,同时推动“可再生能源-液冷散热-零碳算力”闭环,为“东数西算”战略提供绿色算力底座。

随着量子计算、脑机接口等新兴技术的发展,数据中心的散热需求将面临新的挑战。中兴通讯将持续加大研发投入,探索新型散热材料和制冷技术,为数据中心的可持续发展提供强大的技术支持。

.png)

.png)